Disco duro

El primer disco duro fue inventado por IBM en 1.956. A lo largo de los años, los discos duros han disminuido su precio al mismo tiempo que han multiplicado su capacidad, siendo la principal opción de almacenamiento secundario para PC desde su aparición en los años 60. Los discos duros han mantenido su posición dominante gracias a los constantes incrementos en la densidad de grabación, que se ha mantenido a la par de las necesidades de almacenamiento secundario.

Los tamaños también han variado mucho, desde los primeros discos IBM hasta los formatos estandarizados actualmente: 3,5" los modelos para PC’s y servidores, 2,5" los modelos para dispositivos portátiles. Todos se comunican con la computadora a través del controlador de disco, empleando un interfaz estandarizado. Los más comunes hoy día son IDE (también llamado ATA o PATA), SCSI (generalmente usado en servidores y estaciones de trabajo), Serial ATA y FC (empleado exclusivamente en servidores).

Para poder utilizar un disco duro, un sistema operativo debe aplicar un formato de bajo nivel que defina una o más particiones. La operación de formateo requiere el uso de una fracción del espacio disponible en el disco, que dependerá del formato empleado. Además, los fabricantes de discos duros, SSD y tarjetas flash miden la capacidad de los mismos usando prefijos SI, que emplean múltiplos de potencias de 1000 según la normativa IEC, en lugar de los prefijos binarios clásicos de la IEEE, que emplean múltiplos de potencias de 1024, y son los usados mayoritariamente por los sistemas operativos. Esto provoca que en algunos sistemas operativos sea representado como múltiplos 1024 o como 1000, y por tanto existan ligeros errores, por ejemplo un Disco duro de 500 GB, en algunos sistemas operativos sea representado como 465 GiB (Según la IEC Gibibyte, o Gigabyte binario, que son 1024 Mebibytes) y en otros como 465 GB.

Existe otro tipo de almacenamiento que recibe el nombre de Unidades de estado sólido; aunque tienen el mismo uso y emplean los mismos interfaces, no están formadas por discos mecánicos, sino por memorias de circuitos integrados para almacenar la información. El uso de esta clase de dispositivos anteriormente se limitaba a las supercomputadoras, por su elevado precio, aunque hoy en día ya son muchísimo más asequibles para el mercado doméstico.

Estructura física

Cada plato posee dos caras, y es necesaria una cabeza de lectura/escritura para cada cara. Si se observa el esquema Cilindro-Cabeza-Sector de más abajo, a primera vista se ven 4 brazos, uno para cada plato. En realidad, cada uno de los brazos es doble, y contiene 2 cabezas: una para leer la cara superior del plato, y otra para leer la cara inferior. Por tanto, hay 8 cabezas para leer 4 platos, aunque por cuestiones comerciales, no siempre se usan todas las caras de los discos y existen discos duros con un número impar de cabezas, o con cabezas deshabilitadas. Las cabezas de lectura/escritura nunca tocan el disco, sino que pasan muy cerca (hasta a 3 nanómetros), debido a una finísima película de aire que se forma entre éstas y los platos cuando éstos giran (algunos discos incluyen un sistema que impide que los cabezales pasen por encima de los platos hasta que alcancen una velocidad de giro que garantice la formación de esta película). Si alguna de las cabezas llega a tocar una superficie de un plato, causaría muchos daños en él, rayándolo gravemente, debido a lo rápido que giran los platos (uno de 7.200 revoluciones por minuto se mueve a 129 km/h en el borde de un disco de 3,5 pulgadas).

Los componentes físicos de una unidad de disco duro son:

LOS DISCOS (Platters)

Están elaborados de compuestos de vidrio, cerámica o aluminio finalmente pulidos y revestidos por ambos lados con una capa muy delgada de una aleación metálica. Los discos están unidos a un eje y un motor que los hace guiar a una velocidad constante entre las 3600 y 7200 RPM. Convencionalmente los discos duros están compuestos por varios platos, es decir varios discos de material magnético montados sobre un eje central. Estos discos normalmente tienen dos caras que pueden usarse para el almacenamiento de datos, si bien suele reservarse una para almacenar información de control.

LAS CABEZAS (Heads)

Están ensambladas en pila y son las responsables de la lectura y la escritura de los datos en los discos. La mayoría de los discos duros incluyen una cabeza Lectura/Escritura a cada lado del disco, sin embargo algunos discos de alto desempeño tienen dos o más cabezas sobre cada superficie, de manera que cada cabeza atiende la mitad del disco reduciendo la distancia del desplazamiento radial. Las cabezas de Lectura/Escritura no tocan el disco cuando este esta girando a toda velocidad; por el contrario, flotan sobre una capa de aire extremadamente delgada (10 millonésima de pulgada). Esto reduce el desgaste en la superficie del disco durante la operación normal, cualquier polvo o impureza en el aire puede dañar suavemente las cabezas o el medio. Su funcionamiento consiste en una bobina de hilo que se acciona según el campo magnético que detecte sobre el soporte magnético, produciendo una pequeña corriente que es detectada y amplificada por la electrónica de la unidad de disco.

EL EJE

Es la parte del disco duro que actúa como soporte, sobre el cual están montados y giran los platos del disco.

"ACTUADOR" (actuator)

Es un motor que mueve la estructura que contiene las cabezas de lectura entre el centro y el borde externo de los discos. Un "actuador" usa la fuerza de un electromagneto empujado contra magnetos fijos, para mover las cabezas a través del disco. La controladora manda más corriente a través del electromagneto para mover las cabezas cerca del borde del disco. En caso de una perdida de poder, un resorte mueve la cabeza nuevamente hacia el centro del disco sobre una zona donde no se guardan datos. Dado que todas las cabezas están unidas al mismo "rotor" ellas se mueven al unísono. Mientras que lógicamente la capacidad de un disco duro puede ser medida según los siguientes parámetros:

Cilindros (cylinders)

El par de pistas en lados opuestos del disco se llama cilindro. Si el HD contiene múltiples discos (sean n), un cilindro incluye todos los pares de pistas directamente uno encima de otra (2n pistas). Los HD normalmente tienen una cabeza a cada lado del disco. Dado que las cabezas de Lectura/Escritura están alineadas unas con otras, la controladora puede escribir en todas las pistas del cilindro sin mover el rotor. Como resultado los HD de múltiples discos se desempeñan levemente más rápido que los HD de un solo disco.

Pistas (tracks)

Un disco está dividido en delgados círculos concéntricos llamados pistas. Las cabezas se mueven entre la pista más externa ó pista cero a la mas interna. Es la trayectoria circular trazada a través de la superficie circular del plato de un disco por la cabeza de lectura / escritura. Cada pista está formada por uno o más Cluster. Sectores (sectors)

Un byte es la unidad útil más pequeña en términos de memoria. Los HD almacenan los datos en pedazos gruesos llamados sectores. La mayoría de los HD usan sectores de 512 bytes. La controladora del H D determina el tamaño de un sector en el momento en que el disco es formateado. Algunos modelos de HD le permiten especificar el tamaño de un sector. Cada pista del disco esta dividida en 1 ó 2 sectores dado que las pistas exteriores son más grandes que las interiores, las exteriores contienen más sectores.

Distribución de un disco duro

Cluster

Es una agrupación de sectores, su tamaño depende de la capacidad del disco. La siguiente tabla nos muestra esta relación.

| Tamaño del Drive MB | Tipo de FAT bits | Sectores por Cluster | Tamaño del Cluster Kb |

| 0 –15 | 12 | 8 | 4 |

| 16-127 | 16 | 4 | 2 |

| 128-255 | 16 | 8 | 4 |

| 256-511 | 16 | 16 | 8 |

| 512-1023 | 16 | 32 | 16 |

| 1024-2048 | 16 | 64 | 32 |

MEDIDAS QUE DESCRIBEN EL DESEMPEÑO DE UN HD

Los fabricantes de HD miden la velocidad en términos de tiempo de acceso, tiempo de búsqueda, latencia y transferencia. Estas medidas también aparecen en las advertencias, comparaciones y en las especificaciones. Tiempo de acceso ( access time) Termino frecuentemente usado en discusiones de desempeño, es el intervalo de tiempo entre el momento en que un drive recibe un requerimiento por datos, y el momento en que un drive empieza a despachar el dato. El tiempo de acceso de un HD es una combinación de tres factores:

1- Tiempo de Búsqueda (seek time)

Es el tiempo que le toma a las cabezas de Lectura/Escritura moverse desde su posición actual hasta la pista donde esta localizada la información deseada. Como la pista deseada puede estar localizada en el otro lado del disco o en una pista adyacente, el tiempo de búsqueda variara en cada búsqueda. En la actualidad, el tiempo promedio de búsqueda para cualquier búsqueda arbitraria es igual al tiempo requerido para mirar a través de la tercera parte de las pistas. Los HD de la actualidad tienen tiempos de búsqueda pista a pista tan cortos como 2 milisegundos y tiempos promedios de búsqueda menores a 10 milisegundos y tiempo máximo de búsqueda (viaje completo entre la pista más interna y la más externa) cercano a 15 milisegundos .

2- Latencia (latency)

Cada pista en un HD contiene múltiples sectores una vez que la cabeza de Lectura/Escritura encuentra la pista correcta, las cabezas permanecen en el lugar e inactivas hasta que el sector pasa por debajo de ellas. Este tiempo de espera se llama latencia. La latencia promedio es igual al tiempo que le toma al disco hacer media revolución y es igual en aquellos drivers que giran a la misma velocidad. Algunos de los modelos más rápidos de la actualidad tienen discos que giran a 10000 RPM o más reduciendo la latencia.

3- Command Overhead

Tiempo que le toma a la controladora procesar un requerimiento de datos. Este incluye determinar la localización física del dato en el disco correcto, direccionar al "actuador" para mover el rotor a la pista correcta, leer el dato, redireccionarlo al computador.

Transferencia

Los HD también son evaluados por su transferencia, la cual generalmente se refiere al tiempo en la cual los datos pueden ser leídos o escritos en el drive, el cual es afectado por la velocidad de los discos, la densidad de los bits de datos y el tiempo de acceso. La mayoría de los HD actuales incluyen una cantidad pequeña de RAM que es usada como cache o almacenamiento temporal. Dado que los computadores y los HD se comunican por un bus de Entrada/Salida, el tiempo de transferencia actual entre ellos esta limitado por el máximo tiempo de transferencia del bus, el cual en la mayoría de los casos es mucho más lento que el tiempo de transferencia del drive.

COMO FUNCIONA UN DISCO DURO

1. Una caja metálica hermética protege los componentes internos de las partículas de polvo; que podrían obstruir la estrecha separación entre las cabezas de lectura/escritura y los discos, además de provocar el fallo de la unidad a causa de la apertura de un surco en el revestimiento magnético de un disco. 2. En la parte inferior de la unidad, una placa de circuito impreso, conocida también como placa lógica, recibe comandos del controlador de la unidad, que a su vez es controlado por el sistema operativo. La placa lógica convierte estos comandos en fluctuaciones de tensión que obligan al actuador de las cabezas a mover estas a lo largo de las superficies de los discos. La placa también se asegura de que el eje giratorio que mueve los discos de vueltas a una velocidad constante y de que la placa le indique a las cabezas de la unidad en que momento deben leer y escribir en el disco. En un disco IDE (Electrónica de Unidades Integradas), el controlador de disco forma parte de la placa lógica. 3. Un eje giratorio o rotor conectado a un motor eléctrico hacen que los discos revestidos magnéticamente giren a varios miles de vueltas por minuto. El número de discos y la composición del material magnético que lo s recubre determinan la capacidad de la unidad. Generalmente los discos actuales están recubiertos de una aleación de aproximadamente la trillonésima parte del grosor de una pulgada. 4. Un actuador de las cabezas empuja y tira del grupo de brazos de las cabezas de lectura/escritura a lo largo de las superficies de los platos con suma precisión. Alinea las cabezas con las pistas que forman círculos concéntricos sobre la superficie de los discos. 5. Las cabezas de lectura/escritura unidas a los extremos de los brazos móviles se deslizan a la vez a lo largo de las superficies de los discos giratorios del HD. Las cabezas escriben en los discos los datos procedentes del controlador de disco alineando las partículas magnéticas sobre las superficies de los discos; las cabezas leen los datos mediante la detección de las polaridades de las partículas ya alineadas. 6. Cuando el usuario o su software le indican al sistema operativo que lea o escriba un archivo, el sistema operativo ordena al controlador del HD que mueva las cabezas de lectura y escritura a la tabla de asignación de archivos de la unidad, o FAT en DOS (VFAT en Windows 95). El sistema operativo lee la FAT para determinar en que Cluster del disco comienza un archivo preexistente, o que zonas del disco están disponibles para albergar un nuevo archivo. 7. Un único archivo puede diseminarse entre cientos de Cluster independientes dispersos a lo largo de varios discos. El sistema operativo almacena el comienzo de un archivo en los primeros Cluster que encuentra enumerados como libres en la FAT. Esta mantiene un registro encadenado de los Cluster utilizados por un archivo y cada enlace de la cadena conduce al siguiente Cluster que contiene otra parte más del archivo. Una vez que los datos de la FAT han pasado de nuevo al sistema operativo a través del sistema electrónico de la unidad y del controlador del HD, el sistema operativo da instrucciones a la unidad para que omita la operación de las cabezas de lectura/escritura a lo largo de la superficie de los discos, leyendo o escribiendo los Cluster sobre los discos que giran después de las cabezas. Después de escribir un nuevo archivo en el disco, el sistema operativo vuelve a enviar las cabezas de lectura/escritura a la FAT, donde elabora una lista de todos los Cluster del archivo.

INTERFAZ ENHANCED INTEGRATED DRIVE ELECTRONICS (EIDE)

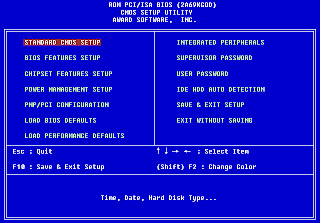

La norma IDE fue desarrollada por Western Digital y Compaq Computers a partir de una interfaz de disco del AT original que IBM creó en 1984. Desde entonces se convirtió en la interfaz más utilizada en el entorno PC. A pesar de esto IDE presenta unas limitaciones debido a su dependencia de la BIOS y al diseño del que parte. Hace poco las limitaciones en el tamaño de los HD y la velocidad de transferencia no daban problemas, pero como se han mejorado los procesadores y han salido programas más complejos, ya se notan.

Entonces se hizo un mejoramiento de las normas IDE y surgió Enhanced IDE, por cierto la nomenclatura de estas normas son similares a las de SCSI. Así, partiendo de la interfaz establecido de IDE llamado ATA (AT Attachment) surge ATA-2 y ATAPI (ATA Packed Interfaz), que permite conectar unidades de CD-ROM a controladores ATA.

ATA-2 se encuentra en proceso de normalización, permite alcanzar 16.6 Mbps (según el tipo de periférico que prestan las E/S); según su esquema de translación de direcciones se pueden encontrar dos métodos en ATA-2:

- Mediante el tradicional sistema de cilindros/Cabezas/Sectores (CHS). De esta forma se transforman los parámetros de CHS de la Bios en los de la unidad. Como ventaja tiene su sencillez.

- Mediante LBA (Logical Block Address). Consiste en transformar los parámetros CHS en una dirección de 28 bits que puede ser usada por el sistema Operativo, los drives de los dispositivos, etc.

En ambos casos se necesita una BIOS extra para permitir superar la limitación de 528 Mb.

Ventajas De Enhanced IDE:

*Máximo cuatro dispositivos conectados

*Soporta CD-ROM y cinta

*Transparencia de hasta 16.6 Mbps

*Capacidad máxima de 8.4 Gbytes

Velocidades en ATA-2

*11.1 con PIO Modo3

*13.3 Mbps con DMA Modo1

*16.6 Mbps con PIO Modo4

DEFINICIONES DE TERMINOS

ATA (AT Attachment), dispositivo de AT. Es el dispositivo IDE que más se usa en la actualidad, por los que a veces se confunde con el propio IDE. Originalmente se creó para un bus ISA de 16 bits.

ATAPI (ATA PACKET INTAERFACE), Interfaz de paquete ATA. Es una extensión del protocolo ATA para conseguir una serie de comandos y registros que controlen el funcionamiento de un CD-ROM, es fácilmente adaptable para una cinta de Backup.

DMA (DIRECT MEMORY ACCESS), Acceso directo a memoria. Componente integrado en un periférico que libera al procesador en la tarea de transferir datos entre dispositivos y memoria. El acceso se realiza por bloque de datos.</ P>

PIO (PROGRAMABLE INPUT/OUTPUT), Entrada/Salida programable. Componente encargado de ejecutar las instrucciones dirigidas a los periféricos. A diferencia de la DMA requiere atención del procesador para su funcionamiento. Como contrapartida es mucho más sencillo y barato.

Controladoras

La interface es la conexión entre el mecanismo de la unidad de disco y el bus del sistema. Define la forma en que las señales pasan entre el bus del sistema y el disco duro. En el caso del disco, se denomina controladora o tarjeta controladora, y se encarga no sólo de transmitir y transformar la información que parte de y llega al disco, sino también de seleccionar la unidad a la que se quiere acceder, del formato, y de todas las órdenes de bajo nivel en general. La controladora a veces se encuentra dentro de la placa madre.

Se encuentran gobernados por una controladora y un determinado interface que puede ser:

· ST506: Es un interface a nivel de dispositivo; el primer interface utilizado en los PC’s. Proporciona un valor máximo de transferencia de datos de menos de 1 Mbyte por segundo. Actualmente esta desfasado y ya no hay modelos de disco duro con este tipo de interface.

· ESDI: Es un interface a nivel de dispositivo diseñado como un sucesor del ST506 pero con un valor más alto de transferencia de datos (entre 1,25 y 2.5 Mbytes por segundo).Ya ha dejado de utilizarse este interface y es difícil de encontrar.

· IDE: Es un interface a nivel de sistema que cumple la norma ANSI de acoplamiento a los AT y que usa una variación sobre el bus de expansión del AT (por eso también llamados discos tipo AT) para conectar una unidad de disco a la CPU, con un valor máximo de transferencia de 4 Mbytes por segundo. En principio, IDE era un término genérico para cualquier interface a nivel de sistema. La especificación inicial de este interface está mal definida. Es más rápida que los antiguos interfaces ST506 y ESDI pero con la desaparición de los ATs este interface desaparecerá para dejar paso al SCSI y el SCSI-2.

Íntimamente relacionado con el IDE, tenemos lo que se conoce como ATA, concepto que define un conjunto de normas que deben cumplir los dispositivos. Años atrás la compañía Western Digital introdujo el standard E-IDE (Enhanced IDE), que mejoraba la tecnología superando el límite de acceso a particiones mayores de 528 Mb. y se definió ATAPI, normas para la implementación de lectores de CD-ROM y unidades de cinta con interfaz IDE. E-IDE se basa en el conjunto de especificaciones ATA-2. Como contrapartida comercial a E-IDE, la empresa Seagate presento el sistema FAST-ATA-2, basado principalmente en las normas ATA-2. En cualquier caso a los discos que sean o bien E-IDE o FAST-ATA, se les sigue aplicando la denominación IDE como referencia. Para romper la barrera de los 528 Mb. las nuevas unidades IDE proponen varias soluciones:

* El CHS es una traducción entre los parámetros que la BIOS contiene de cilindros, cabezas y sectores (ligeramente incongruentes) y los incluidos en el software de sólo lectura (Firmware) que incorpora la unidad de disco.

* El LBA (dirección lógica de bloque), estriba en traducir la información CHS en una dirección de 28 bits manejables por el sistema operativo, para el controlador de dispositivo y para la interfaz de la unidad.

Debido a la dificultad que entraña la implemetación de la compatibilidad LBA en BIOS, muchos de los ordenadores personales de fabricación más reciente continúan ofreciendo únicamente compatibilidad con CHS. El techo de la capacidad que permite la solución CHS se sitúa en los 8,4 Gb, que por el momento parecen suficientes.

· SCSI: Es un interface a nivel de sistema, diseñado para aplicaciones de propósito general, que permite que se conecten hasta siete dispositivos a un único controlador. Usa una conexión paralela de 8 bits que consigue un valor máximo de transferencia de 5 Mbytes por segundo. Actualmente se puede oír hablar también de SCSI-2 que no es más que una versión actualizada y mejorada de este interface. Es el interface con más futuro, si bien tiene problemas de compatibilidad entre las diferentes opciones de controladoras, discos duros, impresoras, unidades de CD-ROM y demás dispositivos que usan este interface debido a la falta de un estándar verdaderamente sólido.

Las mejoras del SCSI-2 sobre el SCSI tradicional son el aumento de la velocidad a través del bus, desde 5 Mhz a 10 Mhz, duplicando de esta forma el caudal de datos. Además se aumenta el ancho del bus de 8 a 16 bits, doblando también el flujo de datos. Actualmente se ha logrado el ancho de 32 bits, consiguiendo velocidades teóricas de hasta 40 Mbytes / seg.

Los interfaces IDE y SCSI llevan la electrónica del controlador en el disco, por lo que el controlador realmente no suele ser mas que un adaptador principal para conectar el disco al PC. Como se puede ver unos son interfaces a nivel de dispositivo y otros a nivel de sistema, la diferencia entre ambos es:

INTERFACE A NIVEL DE DISPOSITIVO: Es un interface que usa un controlador externo para conectar discos al PC. Entre otras funciones, el controlador convierte la ristra de datos del disco en datos paralelos para el bus del microprocesador principal del sistema. ST506 y ESDI son interfaces a nivel de dispositivo.

INTERFACE A NIVEL DE SISTEMA: Es una conexión entre el disco duro y su sistema principal que pone funciones de control y separación de datos sobre el propio disco (y no en el controlador externo), SCSI e IDE son interfaces a nivel de sistema.

Distribución de la Información : Grabación y Acceso.

Para grabar información en la superficie, se siguen una serie de códigos, que transforman un patrón de bits en una secuencia de celdas con diferentes estados de magnetización.

Procesos de grabación

· GCR (Group Coding Recording - Codificación de grupo de grabación) Es un proceso de almacenamiento en el que los bits se empaquetan como grupos y son almacenados bajo un determinado código.

· ZBR (Zone Bit Recording) Es un proceso de almacenamiento que coloca más sectores sobre las pistas exteriores del disco que son más largas, pero mantienen un valor constante de rotación. Está diseñado para colocar más datos sobre el disco, sólo puede usarse con interfaces inteligentes.

Proceso de Codificación

· FM: Es la codificación más sencilla, consiste en la grabación de un cambio de flujo para cada uno, y el omitir el cambio de flujo para cada cero. Este procedimiento se puede realizar con una electrónica de control relativamente simple, pero tiene el inconveniente de que cada bit de datos consume dos cambios de flujo, limitando mucho la capacidad del disco.

· MFM (Modified Frequency Modulation - Modulación de frecuencia modificada) Método de codificación magnética de la información que crea una correspondencia 1 a 1 entre los bits de datos y transiciones de flujo (cambios magnéticos) sobre un disco. Emplea una menor densidad de almacenamiento y presenta una velocidad más baja de transferencia que el RLL.

Esta tecnología es usada en los discos flexibles y en los primeros discos duros. Cada bit de datos es almacenado sobre una región física lo suficientemente grande para contener 2 posibles posiciones 00, 01 ó 10. Entre cada 2 bits de datos hay un bit que se llama de "reloj" y que se usa para validar las lecturas, así como para sincronizarlas. Este bit hace que sea uno cuando está situado entre 2 bits de datos a cero y se hace cero cuando está situado entre cualquier otra combinación de bits de datos. Así se hace imposible que se puedan leer más de 3 bits consecutivos con un valor de cero, o mas de un bit seguido a uno. Esto es cierto para todas las informaciones almacenadas en el disco excepto para las áreas de control del mismo cuyas marcas de comienzo de pista, sector y datos tienen 4 bits consecutivos a cero en su "adress mark". Evidentemente, estos sistemas, aunque fiables, son unos grandes consumidores de espacio ya que emplean prácticamente la mitad del espacio en bits de reloj.

· RLL: (Run Length Limited - Longitud recorrido limitado) Método de codificar la información magnéticamente que usa GCR para almacenar bloques en vez de bits individuales de datos. Permite densidades mayores de almacenamiento y velocidades mas altas de transferencia que MFM. En la práctica, permite incrementar en un 50% la capacidad de un disco respecto al sistema de grabación MFM. Los métodos de grabación RLL utilizan un conjunto complejo de reglas para determinar el patrón de pulsos para cada bit basado en los valores de los bits precedentes. Este sistema se puede clasificar dependiendo de la distancia máxima y mínima de silencios entre dos pulsos, por ejemplo; el RLL 2,7 tiene una distancia mínima entre pulsos de 2 silencios y una máxima de 7.

Datos de control del disco

Es casi imposible evitar impurezas en la superficie magnética del disco, esto provoca que existan determinados sectores que son defectuosos.

En los antiguos discos estos sectores venían apuntados por el control de calidad del fabricante del disco. En el formateo de bajo nivel, el usuario debería indicárselos al programa formateador. En los modernos, las direcciones de estos sectores se graban en pistas especiales o se reconocen durante el formateo a bajo nivel del disco, estos sectores se saltan o bien son sustituidos por otros que están en zonas protegidas. Es allí donde se guardan las tablas que marcan los sectores defectuosos y sus sustituciones. Esto disminuye el acceso al disco duro, pero teniendo en cuenta que el porcentaje de sectores defectuosos es mínimo, prácticamente no tiene importancia.

Hay que tener en cuenta que no toda la información que se encuentra en la superficie de los discos son datos, existen zonas donde se almacena información de control.

Entre la información que se encuentran dentro de un sector:

· Numero de sector y cilindro

· El ECC (Error Correction Code) DATA.

· La zona de datos

· Zonas de separación entre zonas o entre pistas

También existen pistas extra donde se recogen otras informaciones como:

· Pistas "servo" donde se guardan cambios de flujo según un esquema determinado, para la sincronización al pulso de datos, necesario para la correcta compresión de las informaciones en RLL.

· Pistas de reserva, normalmente usadas como reserva de sectores defectuosos.

· Pistas de aparcamiento, usadas para retirar los cabezales evitando así choques del cabezal con la superficie con datos ante vibraciones o golpes de la unidad.

Tiempos de acceso, Velocidades y su medición

Existen una serie de Factores de Velocidad relacionados con los discos duros que son necesarios conocer para comprender su funcionamiento y sus diferencias.

· Tiempo de búsqueda de pista a pista: intervalo de tiempo necesario para desplazar la cabeza de lectura y escritura desde una pista a otra adyacente.

· Tiempo medio de acceso: tiempo que tarda, como media, para desplazarse la cabeza a la posición actual. Este tiempo promedio para acceder a una pista arbitraria es equivalente al tiempo necesario para desplazarse sobre 1/3 de las pistas del disco duro. El antiguo IBM PC/XT utilizaba discos de 80 a 110 milisegundos, mientras que los AT usaban discos de 28 a 40 milisegundos, y los actuales sistemas 386, 486 y PENTIUMÒ usan discos de menos de 20 milisegundos.

· Velocidad de Rotación: Número de vueltas por minuto (RPM) que da el disco.

· Latencia Promedio: Es el promedio de tiempo para que el disco una vez en la pista correcta encuentre el sector deseado, es decir el tiempo que tarda el disco en dar media vuelta. Velocidad de transferencia: velocidad a la que los datos (bits) pueden transferirse desde el disco a la unidad central. Depende esencialmente de dos factores: la velocidad de rotación y la densidad de almacenamiento de los datos en una pista

3600 rpm = 1 revolución cada 60/3600 segundos (16,66 milisegundos)

Si calculamos el tiempo de ½ vuelta --> Latencia Promedio 8,33 milisegundos

Una comparativa entre un disquete y un disco duro de todos estos Factores mencionados anteriormente sería:

| | T.Pista | T.MAcceso | Rotación | Latencia | V.Transfrencia |

| FD 360k HD AT 30 | 6-12 mls 8-10 mls | 93 mls 40-28 mls | 300 rpm 3600 rpm | 100 mls 8,3 mls | 125-250 Kb / seg 1-5 Mb / seg |

El tiempo de búsqueda depende del tamaño de la unidad (2", 3"½, 5"¼), del número de pistas por pulgada (que a su vez depende de factores como el tamaño de los dominios magnéticos) y de la velocidad y la precisión de los engranajes del cabezal. La latencia depende de la velocidad de rotación y equivale a la mitad del tiempo que tarda el disco en describir un giro completo. El rendimiento total también depende de la disposición de los dominios magnéticos, uso de ZBR.

Para mejorar el tiempo de acceso se reduce esa latencia acelerando la rotación del disco o velocidad de eje. Hace unos años todos los discos duros giraban a la misma velocidad unos 3600 rpm, la latencia resultante era de 8,3 milisegundos. Hoy las unidades de disco más rápidas para PC giran a 5400 rpm (un 50% más rápidas) y por tanto su latencia es de 5,6 milisegundos. Algunos discos siguen usando los 3600 rpm para consumir menos energía.

| RPM | 1 Vuelta cada | Latencia |

| 3600 | 16,66 mseg. | 8,33 mseg. |

| 4500 | 13,33 mseg. | 6,66 mseg. |

| 5400 | 11,11 mseg. | 5,55 mseg. |

| 7200 | 8,33 mseg. | 4,16 mseg. |

| 10000 | 6,00 mseg. | 3,00 mseg. |

El trabajar a velocidades elevadas plantea varios problemas: El primer problema es que a esta velocidad la disipación del calor se concierte en un problema. El segundo es que exige a usar nuevos motores articulados pro fluidos para los engranajes, los actuales motores de cojinetes no pueden alcanzar estas velocidades sin una reducción drástica de fiabilidad, se quemarían demasiado rápido.

Además de todas estas características de velocidades y tiempos de acceso de los discos duros existen una serie de técnicas que nos permiten aminorar los accesos a disco así como acelerar las transferencias de datos entre el sistema y el dispositivo en cuestión. Una de las técnicas más conocidas en la informática para hacer esto es la del uso de memorias intermedias, buffers o cachés.

· Buffer De Pista: Es una memoria incluida en la electrónica de las unidades de disco, que almacena el contenido de una pista completa. Así cuando se hace una petición de lectura de una pista, esta se puede leer de una sola vez, enviando la información a la CPU, sin necesidad de interleaving.

· Cachés De Disco: Pueden estar dentro del propio disco duro, en tarjetas especiales o bien a través de programas usar la memoria central. La gestión de esta memoria es completamente invisible y consiste en almacenar en ella los datos más pedidos por la CPU y retirar de ella aquellos no solicitados en un determinado tiempo. Se usan para descargar al sistema de las lentas tareas de escritura en disco y aumentar la velocidad.

Aparte de la velocidad del disco duro y de la controladora la forma en que se transfieren los datos de ésta a la memoria deciden también la velocidad del sistema. Se pueden emplear 4 métodos:

· Programed I/O (Pio Mode): La transferencia de datos se desarrolla a través de los diferentes puerto I/O de la controladora que también sirven para la transmisión de comandos (IN / OUT). La tasa de transferencia está limitada por los valores del bus PC, y por el rendimiento de la CPU. Se pueden lograr transferencias de 3 a 4 Mbytes. Con el modo de transferencia PIO 4, que es el método de acceso que actualmente utilizan los discos más modernos, es posible llegar a tasas de transferencia de 16,6 Mbytes / seg.

· Memory mapped I/O: La CPU puede recoger los datos de la controladora de forma más rápida, si los deja en una zona de memoria fija, ya que entonces se puede realizar la transferencia de los datos a una zona de memoria del programa correspondiente con la introducción MOV, más rápida que los accesos con IN y OUT. El valor teórico máximo es de 8 Mbytes / seg.

· DMA: Es la transferencia de datos desde el disco a la memoria evitando pasar por la CPU. La ventaja de usar el DMA es que se libera al procesador para trabajar en otras tareas mientras las transferencias de datos se realizan por otro lado. El DMA además de ser inflexible es lento, no se puede pasar de más de 2 Mb. por segundo.

· Bus Master DMA: En esta técnica la controladora del disco duro desconecta la controladora del bus y transfiere los datos con la ayuda de un cotrolador Bus Master DMA con control propio. Así se pueden alcanzar velocidades de 8 a 16 Mb. por segundo.

Estructura Lógica De Los Discos Duros

Lo que interrelaciona los discos duros con los disquetes, es su estructura, que se resumen en diferentes funciones del BIOS, que sirven entre otras cosas para el acceso a los mismos.

En primer lugar, internamente los discos duros se pueden dividir en varios volúmenes homogéneos. Dentro de cada volumen se encuentran una estructura que bajo el sistema operativo del Ms-Dos, sería la siguiente:

| Sector de Arranque. |

| Primera tabla de localización de archivos (FAT). |

| Una o más copias de la FAT. |

| Directorio Raíz (eventualmente con etiqueta de volumen). |

| Zona de datos para archivos y subdirectorios. |

Como se muestra en el cuadro anterior, cada volumen se divide en diferentes zonas que por una parte acogen las diferentes estructuras de datos del sistema de archivos, y por otra los diferentes archivos y subdirectorios. En dicho cuadro no se han hecho referencia al tamaño de las diferentes estructuras de datos y zonas. Pero no es posible describirlas, ya que se adaptan individualmente al tamaño del volumen correspondiente

El Sector de Arranque: Al formatear un volumen, el sector de arranque se crea siempre como primer sector del volumen, para que sea fácil de localizar por el DOS. En él se encuentra información acerca del tamaño, de la estructura del volumen y sobre todo del BOOTSTRAP-LOADER, mediante el cual se puede arrancar el PC desde el DOS. A ésta parte se le llama sector de arranque (BOOT).

La Tabla de Asignación de Ficheros (File Allocation Table) (FAT): Si el DOS quiere crear nuevos archivos, o ampliar archivos existentes, ha de saber qué sectores del volumen correspondiente quedan libres, Estas informaciones las toma la llamada FAT. Cada entrada a esta tabla se corresponde con un número determinado de sectores, que son adyacentes lógicamente en el volumen. Cada uno de estos grupos de sectores se llama Cluster. El tamaño de las diferentes entradas de esta tabla en las primeras versiones del DOS era de 12 bits. con lo que se podían gestionar hasta 4.096 Clusters, correspondiente a una capacidad aproximada de 8 Mbytes. En vista del problema que surgió al aparecer discos duros de capacidades más elevadas, se amplió el tamaño a 16 bits., permitiendo el direccionamiento de un máximo de 65.535 Clusters. Actualmente se está creando FAT’s de hasta 32 bits, para discos duros capaces de almacenar Gigas de información.

Una o más copias de la FAT: El DOS permite a un programa de formateo crear no sólo una, sino varias copias idénticas de la FAT. Si el DOS encuentra uno de estos medios, cuida todas las copias de la FAT simultáneamente, así que guarda allí los nuevos clusters ocupados o liberados al crear o borrar archivos. Esto ofrece la ventaja de que se puede sustituir la FAT primaria en caso de defecto por una de sus copias, para evitar la pérdida de datos.

El directorio Raíz: La cantidad máxima de entradas en el directorio raíz se limita por su tamaño, que se fija en el sector de arranque. Ya que el directorio raíz representa una estructura de datos estática, que no crece si se guardan más y más archivos o subdirectorios. De ahí que, dependiendo del tamaño, bien un disco duro o bien de volumen, se selecciona el tamaño del directorio raíz en relación al volumen.

·

La Zona de Datos: Es la parte del disco duro en la que se almacena los datos de un archivo. Esta zona depende en casi su totalidad de las interrelaciones entre las estructuras de datos que forman el sistema de archivos del DOS, y del camino que se lleva desde la FAT hacia los diferentes sectores de un archivo.